Tout le monde teste l'IA... souvent dans son coin. Entre mails reformulés à la volée, prompts partagés en douce et outils non validés, les usages informels explosent. Bonne ou mauvaise nouvelle ? Les deux. Bien pilotés, ces bricolages deviennent un avantage stratégique, une base pour une vraie gouvernance et une montée en compétences durable. Sinon... c'est la porte ouverte aux fuites de données, aux erreurs et aux tensions internes.

© BravRez

© BravRez

Présentation : de l'IA officieuse aux risques... et aux opportunités

En 2024, 65 % des organisations interrogées disaient déjà utiliser l'IA générative régulièrement, presque deux fois plus qu'un an plus tôt, et 75 % des travailleurs du savoir l'avaient intégrée à leur quotidien (souvent sans cadre clair). Dans le même temps, près d'une entreprise sur deux affirme avoir subi au moins une conséquence négative liée à ces usages (qualité, sécurité, réputation...). Autrement dit, l'IA est là, mais la manière dont elle est utilisée fait toute la différence.

Le rapport Inria x datacraft parle de « Shadow AI » pour désigner ces pratiques d'IA générative en dehors des radars officiels. Disons-le autrement : des usages informels, bricolés, parfois cachés, parfois tolérés, mais rarement structurés. L'étude montre que cette zone grise n'est pas qu'un danger à neutraliser, c'est un laboratoire d'innovation grandeur nature, à condition de la rendre visible et gouvernable.

Pourquoi maintenant ? Parce que le décalage persiste entre ambitions stratégiques et travail réel. Après une décennie de PoC, seuls 20 % passent en production... le reste s'évapore. Ce chiffre résume le problème : trop de projets top-down, pas assez ancrés dans les gestes métiers. Les usages informels, eux, collent au besoin concret du terrain... mais manquent de cadre.

Pourquoi en parler maintenant ?

Parce que les collaborateurs avancent, avec ou sans vous. Ils traduisent, rédigent, synthétisent, explorent avec des IA accessibles en quelques clics. Ils n'attendent pas l'outil officiel. Quand la posture de l'entreprise est floue, ils se cachent. Quand elle est claire, ils partagent. Et quand ils partagent, l'organisation apprend plus vite et sécurise mieux.

Objectif : transformer les bricolages individuels en capital stratégique

L'enjeu n'est donc pas d'interdire par principe, ni de laisser faire sans filet. Il est de transformer ce capital informel en intelligence collective, puis en avantage compétitif. Cela suppose un chemin négocié, progressif, qui part du réel.

Piloter : rendre visible sans punir

But : Nommer les usages existants, évaluer les risques, poser des garde-fous minimaux. Concrètement, on ne « flique » pas, on cartographie. Sondages anonymes, ateliers métiers, recensement des prompts utiles... La transparence est le point de départ, pas l'aboutissement.

- Identifier où, pourquoi et comment l'IA est utilisée aujourd'hui

- Repérer les flux de données sensibles et les outils non validés

- Qualifier les bénéfices et les irritants (temps gagné, qualité, stress, etc.)

Ce diagnostic fait gagner du temps : il évite de réinventer la roue et révèle des cas d'usage prioritaires à industrialiser.

Partager : socialiser les pratiques et les critères de qualité

But : Sortir de l'individualisme, reconnaître les savoir-faire diffus et co-définir ce qu'est un travail « bien fait avec l'IA ». Les tensions vitesse vs rigueur, autonomie vs conformité ne sont pas des obstacles, mais des ressources pour clarifier les attentes.

- Organiser des sessions de partage de prompts (15 minutes suffisent, tout le monde peut jouer le jeu)

- Mettre en débat des cas concrets : où l'IA aide, où elle dégrade la qualité

- Documenter les "bons réflexes" de vérification et de traçabilité

Ce travail collectif légitime les usages, évite la culpabilité et renforce la cohésion. Les collaborateurs deviennent des praticiens lucides, pas des utilisateurs clandestins.

Outiller et sécuriser : fournir des solutions validées et un cadre de confiance vivant

But : Mettre à disposition des environnements sécurisés, clarifier les règles d'usage et les responsabilités, tout en gardant de la souplesse. On parle de chartes dynamiques, de guides pratiques, de sandbox internes, pas de règlements gravés dans le marbre.

- Définir clairement les données autorisées ou interdites dans les outils

- Préciser "qui répond de quoi" en cas d'erreur ou de fuite

- Instaurer des mécanismes légers de supervision et de feedback

- Mettre à jour régulièrement le cadre selon les retours terrain

Résultat : les risques deviennent gouvernables collectivement et les innovations ne restent pas coincées au stade de l'expérimentation.

Former : au-delà du prompt, développer un jugement professionnel

But : Articuler compétences techniques et lucidité critique. Maîtriser l'outil, comprendre ses limites, savoir quand vérifier, quand escalader, quand refuser.Cela inclut l'éthique, le juridique, la sécurité, mais aussi la posture de supervision managériale.

Les leaders le disent : ils veulent des talents capables d'utiliser l'IA, mais peinent encore à mesurer les gains et à fixer un cap. Former, c'est aussi répondre à ce besoin de vision partagée. Et c'est ce qui distingue les « AI Leaders » du peloton, selon plusieurs études : une approche globale, pas seulement outillée.

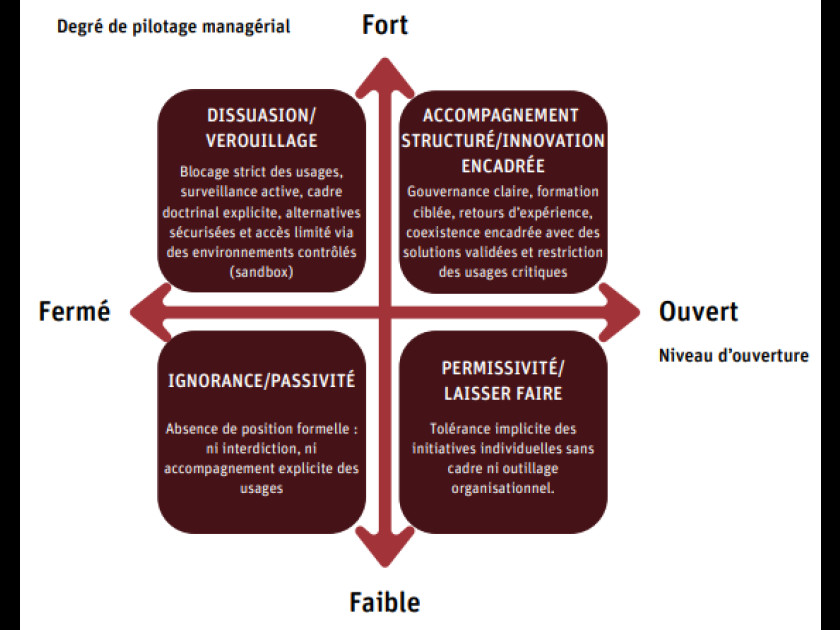

Postures organisationnelles : où êtes-vous, où voulez-vous aller ?

L'étude identifie quatre postures types : dissuasion/verrouillage, ignorance/passivité, permissivité/laissez-faire, accompagnement structuré/innovation encadrée. La trajectoire la plus vertueuse passe rapidement de la tolérance implicite à une gouvernance claire.

Dans les faits, beaucoup d'organisations mixent ces postures selon les domaines : verrouillage sur les processus critiques, permissivité sur les tâches de support, accompagnement structuré sur les projets métier. L'important, c'est d'assumer ces choix, de les expliquer et de prévoir un chemin d'évolution.

© Inria Datacraft

© Inria Datacraft

Nota Bene

« Qualité du travail avec l'IA » : ici, on parle de critères concrets, définis avec les équipes. Fiabilité, traçabilité, conformité, tonalité de marque, etc. Pas seulement de précision algorithmique.

« IA officieuse » : terme volontairement large. Il couvre l'usage de ChatGPT ou d'outils équivalents, mais aussi les fonctionnalités IA intégrées dans des logiciels déjà en place et... pas forcément identifiées comme telles.

Shadow IT vs Shadow AI : on retrouve la même logique côté IT. Jusqu'à 30-40 % des dépenses IT passeraient encore hors contrôle officiel dans certaines grandes structures, ce qui illustre l'ampleur du phénomène d'usages non cadrés.

Conclusion : partir du réel, accélérer sans se brûler

Les usages informels sont là, massifs, créatifs. Les ignorer ou les réprimer revient à se priver d'une étude de marché interne gratuite... et d'un formidable accélérateur de stratégie IA. En partant du terrain, vous pouvez construire une gouvernance ouverte, une formation holistique et un cadre de confiance vivant. Et surtout, vous transformez une pratique clandestine en capital stratégique.

Envie d'agir concrètement ? Nous proposons un diagnostic express de vos usages informels, des ateliers "qualité du travail avec l'IA" et un parcours de formation sur mesure pour vos équipes et vos managers. Contactez-nous, on en parle.

En savoir plus

Questions fréquentes

L'IA officieuse désigne les usages informels de l'IA en dehors des structures officielles, pouvant être un laboratoire d'innovation.

Les risques incluent des fuites de données, des erreurs, et des impacts négatifs sur la qualité et la réputation de l'entreprise.

Il faut rendre ces pratiques visibles, structurer leur utilisation, et les intégrer dans une gouvernance collective.

Former les employés aide à développer leur jugement professionnel et à maîtriser les outils tout en comprenant leurs limites.

Les postures varient de la dissuasion à l'accompagnement structuré, influençant comment l'IA est intégrée dans les processus métiers.